其实谷歌针对发展人工智能的风险的部分也并非光说不练。 近日主动发出了一篇专文,提出了他们建议发展AI人工智能的全新框架Secure AI Framework(简称SAIF)。 无论你是公开或是私下进行训练的 AI 系统,都希望能进一步让大家都能使 AI「负起责任来」打造预设状态下就已足够安全的 AI 系统。 继续阅读谷歌揭露保护人类不受AI威胁的6个核心关键,提供发展人工智能的SAIF框架原则报道内文。

即便在 ChatGPT 突然爆红的前后期看来,谷歌感觉有点像是 Elon Musk 那样,一边叫说 AI 很可怕可能造成灭绝要大家缓一缓,另一边却又在开发自己的生成式 AI。

不过在端出了自己的 Bard AI 之后,其实 Google 针对发展人工智能的风险的部分也并非光说不练。 近日主动发出了一篇专文,提出了他们建议发展AI人工智能的全新框架Secure AI Framework(简称SAIF)。 无论你是公开或是私下进行训练的 AI 系统,都希望能进一步让大家都能「负起责任来」打造预设状态下就已相当安全的 AI 系统。

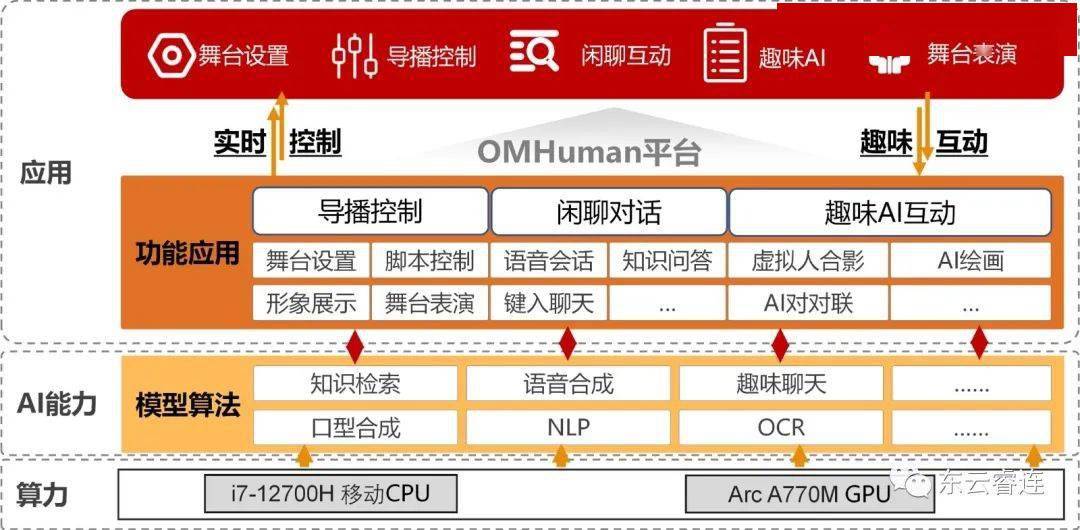

谷歌对此提供了 Secure AI Framework 的 6 个核心元素,包括:

将强大的安全基础建构于 AI 生态系

扩展检测和回应能力,将 AI 纳入组织所具备威胁情境范围内

能应付现有与新威胁的自动化防御机制

能协调平台级的管制确保组织内的安全保护一致

其实谷歌针对发展人工智能的风险的部分也并非光说不练。 近日主动发出了一篇专文,提出了他们建议发展AI人工智能的全新框架Secure AI Framework(简称SAIF)。 无论你是公开或是私下进行训练的 AI 系统,都希望能进一步让大家都能使 AI「负起责任来」打造预设状态下就已足够安全的 AI 系统。 继续阅读谷歌揭露保护人类不受AI威胁的6个核心关键,提供发展人工智能的SAIF框架原则报道内文。

即便在 ChatGPT 突然爆红的前后期看来,谷歌感觉有点像是 Elon Musk 那样,一边叫说 AI 很可怕可能造成灭绝要大家缓一缓,另一边却又在开发自己的生成式 AI。

不过在端出了自己的 Bard AI 之后,其实 Google 针对发展人工智能的风险的部分也并非光说不练。 近日主动发出了一篇专文,提出了他们建议发展AI人工智能的全新框架Secure AI Framework(简称SAIF)。 无论你是公开或是私下进行训练的 AI 系统,都希望能进一步让大家都能「负起责任来」打造预设状态下就已相当安全的 AI 系统。

谷歌对此提供了 Secure AI Framework 的 6 个核心元素,包括:

将强大的安全基础建构于 AI 生态系

扩展检测和回应能力,将 AI 纳入组织所具备威胁情境范围内

能应付现有与新威胁的自动化防御机制

能协调平台级的管制确保组织内的安全保护一致

其实谷歌针对发展人工智能的风险的部分也并非光说不练。 近日主动发出了一篇专文,提出了他们建议发展AI人工智能的全新框架Secure AI Framework(简称SAIF)。 无论你是公开或是私下进行训练的 AI 系统,都希望能进一步让大家都能使 AI「负起责任来」打造预设状态下就已足够安全的 AI 系统。 继续阅读谷歌揭露保护人类不受AI威胁的6个核心关键,提供发展人工智能的SAIF框架原则报道内文。

即便在 ChatGPT 突然爆红的前后期看来,谷歌感觉有点像是 Elon Musk 那样,一边叫说 AI 很可怕可能造成灭绝要大家缓一缓,另一边却又在开发自己的生成式 AI。

不过在端出了自己的 Bard AI 之后,其实 Google 针对发展人工智能的风险的部分也并非光说不练。 近日主动发出了一篇专文,提出了他们建议发展AI人工智能的全新框架Secure AI Framework(简称SAIF)。 无论你是公开或是私下进行训练的 AI 系统,都希望能进一步让大家都能「负起责任来」打造预设状态下就已相当安全的 AI 系统。

谷歌对此提供了 Secure AI Framework 的 6 个核心元素,包括:

将强大的安全基础建构于 AI 生态系

扩展检测和回应能力,将 AI 纳入组织所具备威胁情境范围内

能应付现有与新威胁的自动化防御机制

能协调平台级的管制确保组织内的安全保护一致

其实谷歌针对发展人工智能的风险的部分也并非光说不练。 近日主动发出了一篇专文,提出了他们建议发展AI人工智能的全新框架Secure AI Framework(简称SAIF)。 无论你是公开或是私下进行训练的 AI 系统,都希望能进一步让大家都能使 AI「负起责任来」打造预设状态下就已足够安全的 AI 系统。 继续阅读谷歌揭露保护人类不受AI威胁的6个核心关键,提供发展人工智能的SAIF框架原则报道内文。

即便在 ChatGPT 突然爆红的前后期看来,谷歌感觉有点像是 Elon Musk 那样,一边叫说 AI 很可怕可能造成灭绝要大家缓一缓,另一边却又在开发自己的生成式 AI。

不过在端出了自己的 Bard AI 之后,其实 Google 针对发展人工智能的风险的部分也并非光说不练。 近日主动发出了一篇专文,提出了他们建议发展AI人工智能的全新框架Secure AI Framework(简称SAIF)。 无论你是公开或是私下进行训练的 AI 系统,都希望能进一步让大家都能「负起责任来」打造预设状态下就已相当安全的 AI 系统。

谷歌对此提供了 Secure AI Framework 的 6 个核心元素,包括:

将强大的安全基础建构于 AI 生态系

扩展检测和回应能力,将 AI 纳入组织所具备威胁情境范围内

能应付现有与新威胁的自动化防御机制

能协调平台级的管制确保组织内的安全保护一致

嗯,如果你看到这篇期待的是「机器人三大法则」这种很好懂的原则的话,相信你现在已经头昏眼花。 不过这几个 core elements 还是有一定的逻辑可循的。

简单的讲,前面两项主要是把焦点锁定在加强扩展现有组织的安全框架来对应 AI 的可能威胁。 接下来则是希望导入自动化机制来更弹性对应现有以及未知的威胁。 并且尝试确保这些机制的一致性,然后最终就是希望能确保效率以及面临攻击时不会毫无预警无法分析问题。

谷歌除了在页面上已经提供了如何导入 SAIF 的相关信息。 更宣告将会开始与组织直接合作导入相关的措施。 还扩展了他们除错的相关奖励计划等。

其实光是在目前,就已经有不少尝试侵入破解 AI 语言模型技术的相关技术正在进行当中 - 包括用诱导来让语言模型泄密、以数据资料来导致系统训练出错等。

若是各组织分头努力却没能提供相当的防护机制的话。 姑且不论 AI 会不会发展到像魔鬼终结者那样的程度。 光是掌握某些关键建设的 AI 如果被破解出错导致停摆,其实也就会造成相当程度的灾害了。

所以谷歌跳出来尝试打造可以遵循的框架,真的是拿出了对此的实际作为。 希望这样也能真的带动,让急于发展生成式 AI 的各方,至少能有相当程度的信息安全防护的基础可供依循了。