英伟达近期和康奈尔大学的研究团队合作,推出了名为 VideoLDM模型,可以 根据文本描述,自动 生成最高分辨率 2048*1280、24 帧、最长 4.7 秒的视频。

英伟达表示该模型配有 41 亿个参数,其中 27 亿个经过视频训练,这符合现代生成式 AI 的标准。IT之家从博文中获悉,英伟达表示通过高效的潜在扩散模型(LDM),能够创建多样化、高质量、高清晰度的视频。

以下为英伟达官方对 VideoLDM 模型的解析:

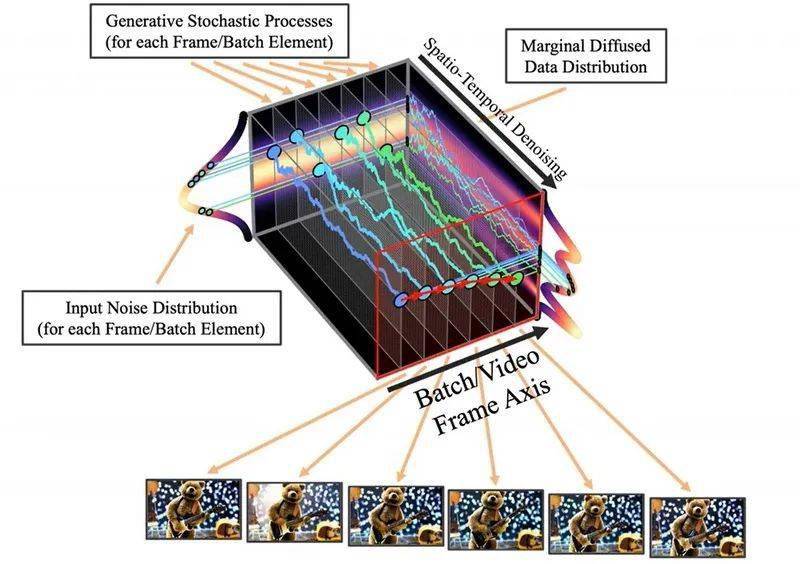

潜在扩散模型 (LDM) 通过在压缩的低维潜在空间中训练扩散模型,在避免过多计算需求的同时实现了高质量的图像合成。

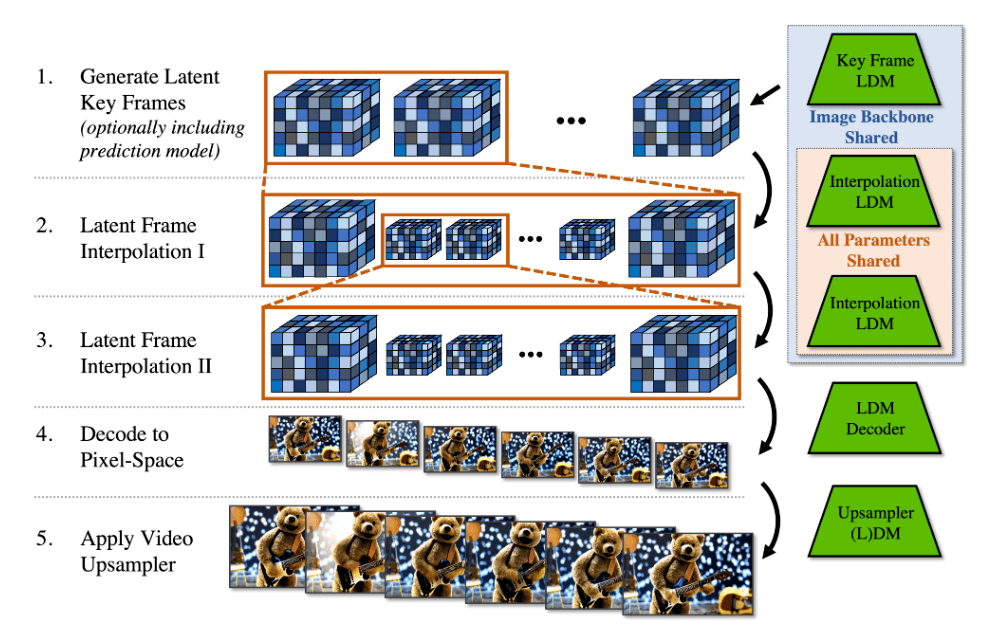

我们将 LDM 范例应用于高分辨率视频生成,这是一个特别资源密集型的任务。

首先对图像进行 LDM 预训练,然后通过在潜在空间扩散模型中引入时间维数并对编码图像序列 (即视频) 进行微调,将图像生成器转换为视频生成器。

之后我们在时间上对齐扩散模型上采样器,将它们转换成时间上一致的视频超分辨率模型。

此外,我们的技术可以很容易地利用现成的预先训练的图像 LDM,因为在这种情况下,只需要训练一个时间对齐模型。

通过这种训练方式,我们将公开可用的、最先进的文本到图像 LDM 稳定扩散转换为高效的、具有表现力的文本到视频模型,分辨率最高可达 1280 x 2048。

我们的研究发现,时间层可以用这种方式训练泛化到不同的微调文本到图像 LDM。利用这一特性,我们显示了个性化的文本到视频生成的第一个结果,为未来的内容创作指出了激动人心的方向。

根据英伟达官方解释,VideoLDM 模型的技术原理就是 先用文本生成多个图像,再 将图像重新组织成为视频。

除此之外,该模型还能创建驾驶场景的视频,视频分辨率为 1024 × 512 像素,最长 5 分钟。英伟达表示目前该项目处于研究阶段,暂时不会向公众开放。